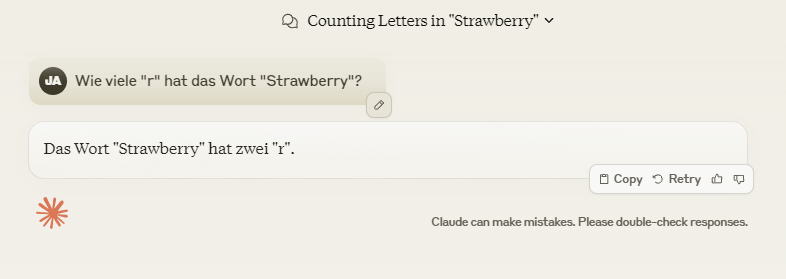

Ich gebe zu, der Titel dieses Beitrags ist etwas provokativ – natürlich absichtlich. Aber das hat seinen Grund. Trotz der beeindruckenden Fortschritte von großen Sprachmodellen (LLMs) in den letzten Jahren stolpern sie immer noch über überraschend einfache Aufgaben. Nehmen wir zum Beispiel diese Frage: Wie viele „r“ sind im Wort „Strawberry“ enthalten? Klingt einfach, oder? Man würde es denken, aber es stellt sich heraus, dass selbst die fortschrittlichsten KI-Modelle oft falsch liegen.

Warum haben KI-Modelle mit einfachen Aufgaben Schwierigkeiten?

Schauen wir uns ein kürzlich eingeführtes Modell an, Reflection 70B. Dieses Modell verwendet eine neue Technik namens „Reflection Tuning“, aber bevor wir darauf eingehen, sehen wir uns an, wie einige bekannte Modelle abschneiden:

Es ist auffällig, dass all diese Systeme Schwierigkeiten mit einer eigentlich einfachen Aufgabe haben: die Anzahl der „r“ in „Strawberry“ zu zählen. Warum passiert das?

Wie funktionieren große Sprachmodelle?

Um diese Fehler zu verstehen, müssen wir kurz erklären, wie LLMs wie GPT-4 oder Claude tatsächlich arbeiten. Diese Modelle basieren auf neuronalen Netzwerken, die darauf trainiert sind, Muster in riesigen Textmengen zu erkennen. Sie lernen, indem sie Textdaten analysieren und vorhersagen, welches Wort oder welche Zeichenfolge als nächstes wahrscheinlich erscheint.

Das Problem ist, dass diese Modelle eigentlich nicht „wissen“, was ein „r“ ist oder wie Wörter aufgebaut sind. Sie operieren auf Basis von Wahrscheinlichkeiten und Kontextvorhersagen. Wenn sie also gefragt werden, die „r“s in „Strawberry“ zu zählen, scannen sie das Wort nicht so, wie es ein Mensch tun würde. Stattdessen suchen sie nach Mustern, die in den Texten, die sie verarbeitet haben, häufig vorkommen, was oft zu unerwarteten oder falschen Ergebnissen führt.

Warum machen LLMs „dumme“ Fehler?

Der Kern dieser Fehler liegt in der Funktionsweise der LLMs. Sie „denken“ nicht wie Menschen. Ihr Verständnis von Sprache ist rein statistisch, basierend auf Mustern, die sie während des Trainings gelernt haben. Aber Fragen, die das Zählen von Buchstaben oder das Analysieren der Wortstruktur erfordern, erfordern eine andere Art der Analyse – etwas direkteres und lineares, jenseits der Mustererkennung.

Eine weitere Herausforderung ist, wie diese Modelle trainiert werden. Sie lernen assoziativ, nicht explizit. Das Zählen von Buchstaben oder das logische Ableiten aus der Struktur eines Wortes gehört nicht zu ihren Stärken. Während sie hervorragend darin sind, Muster zu erkennen und kontextuell relevante Informationen bereitzustellen, scheitern sie bei einfachen, linearen Aufgaben wie dem Zählen von Buchstaben.

Einsatz von Reflection Tuning

Hier kommt Reflection Tuning ins Spiel, das beim Training von Reflection 70B verwendet wurde. Diese Technik ermöglicht es dem Modell, aus seinen eigenen Fehlern zu lernen und sich selbst zu korrigieren. Wenn das Modell also zunächst die falsche Anzahl an „r“s in „Strawberry“ angibt, kann es über seine Antwort nachdenken und sich beim zweiten Versuch korrigieren.

Beispiel von Matt Shumer

Diese Methode ist ein vielversprechender Ansatz, um eines der größten Probleme bei LLMs anzugehen: Halluzinationen. In diesem Zusammenhang beziehen sich Halluzinationen auf Fälle, in denen das Modell falsche oder komplett erfundene Informationen generiert. Mit Reflection Tuning können Modelle wie Reflection 70B potenziell solche Fehler reduzieren, indem sie ihre Ausgaben überprüfen und überarbeiten.

Fazit

Auch wenn die Behauptung, dass KI immer noch „dumm“ sei, nicht in allen Bereichen zutrifft, gibt es bestimmte Aufgaben – wie das Zählen von Buchstaben in einem Wort – bei denen klar wird, dass diese Systeme noch viel lernen müssen. Ihre Abhängigkeit von statistischen Mustern führt zu Fehlern, die für Menschen trivial erscheinen.

Techniken wie Reflection Tuning bieten einen Hoffnungsschimmer, da sie zeigen, dass wir einige dieser Probleme abmildern können. Aber vorerst sollten wir uns der Grenzen aktueller KI-Modelle bewusst bleiben. Sie sind beeindruckend, ohne Frage, aber noch weit davon entfernt, perfekt zu sein.

Quellen:

https://braintitan.medium.com/smarter-ai-reflection-70b-detects-and-fixes-errors-ee0c355750dd

https://cointelegraph.com/news/reflection-70b-ai-model-answer-llm-hallucinations